Pourquoi les médias français se sont-ils si peu saisis du data journalism, à la différence des médias anglosaxons ? Quelques éléments de réponses ont déjà été apportés : par Valérie Peugeot sur www.lavoixdudodo.info et par Elodie Castelli sur www.journalismes.info. Après les études de cas, je vous livre ici ma synthèse. L’occasion de vous faire partager les enseignements tirés de cinq entretiens, réalisés en janvier dernier avec Hubert Guillaud, Jean Marc Manach et Charles Népote de la Fing, avec Fabrice Epelboin de RWW France et avec Nicolas Voisin de Owni.fr.

Comment expliquer le peu d’empressement des rédactions françaises à s’emparer du journalisme de données ? Plusieurs facteurs se combinent, certains relèvent des rédactions, d’autres de leur environnement

Côté rédactions :

Des rédactions en manque de moyens financiers…

Tout d’abord, côté rédactions traditionnelles, la plupart consacrent très peu de ressources à la R&D, et donc à du journalisme d’expérimentation, comme de la visualisation de données. La presse quotidienne n’en a tout simplement pas les moyens, les pure players difficilement. La presse magazine ou le secteur audiovisuel pourraient peut-être parier sur le journalisme de données, mais la crise économique ne les incite pas à de tels investissements.

Quelques exceptions néanmoins : l’Express.fr a recruté deux documentalistes pour réfléchir sur la structuration de données (plus d’info sur le blog d’Eric Mettout) ; France 24 mène un gros travail autour du Web sémantique au sein de son Lab (plus d’info sur le blog de Mikiane)

… en manque de moyens humains

Les rédactions ne sont pas seulement appauvries sur le plan financier, elles manquent aussi de ressources humaines. Car le data journalism nécessite du temps et des compétences : en datamining, en statistiques, en développement, en web-design, en interaction design, en sémiologie visuelle…

Actuellement, personne en France n’a réussi à réunir le bon mix de compétences. Pourtant, c’est sans doute ce qui fait le succès des visualisations du nytimes.com depuis deux ans : le titre fait travailler ensemble des ingénieurs, des infographistes et des journalistes, tous payés le même salaire et sur un même pied d’égalité. Rien à voir avec l’état d’esprit des rédactions françaises, dans lesquelles les « informaticiens » sont déconsidérés.

Ce cloisonnement des rédactions est sans doute un peu moins prégnant lorsqu’on s’intéresse aux rédactions web, mais il n’en reste pas moins un frein au développement du data journalism en France.

… en manque de culture web

Tout simplement, les rédactions traditionnelles n’ont souvent pas l’intuition du data journalism. La plupart du temps, elles ont un train de retard par rapport aux développements du web. Les écoles de journalisme commencent juste à intégrer le journalisme d’innovation et le web dans leurs enseignements. Pour beaucoup des acteurs de ce secteur, cela reste encore un truc de « geek ».

… en manque d’approche statistique

Ce manque d’intuition n’est pas sans rapport avec une culture journalistique très française. Une certaine hagiographie du journalisme made in France prend racine dans l’opposition « facts vs fiction » : opposition entre le journalisme de faits à l’anglo-saxonne et le journalisme littéraire et d’opinion du pays d’Albert Londres. La mythologie journalistique française sacralise la belle plume et le subjectivisme. Sur ce terreau pousse la défiance de nombreux journalistes envers tout ce qui pourrait paraître trop rationaliste, trop technophile ou trop américain.

A ceci s’ajoute la faible culture mathématique, statistique et scientifique de bien des rédacteurs de presse généraliste.

Aversion à mettre les mains dans les données brutes, malaisance avec les valeurs chiffrées, crainte de voir les techniciens commander les rédactions : autant de sensations diffuses qui ne facilitent pas la reconnaissance du data journalism en France.

Pour trouver quelques affinités entre la visualisation de données et l’histoire française, il faut sortir du champ journalistique et se pencher sur celui de la sémiologie. En particulier, la sémiologie graphique, inventée en France par Jacques Bertin, aborde les problématiques de visualisation d’informations géographiques.

Des journalistes américains au service des communautés locales ?

Enfin, une dernière hypothèse pourrait expliquer l’affinité des médias anglosaxons avec le data-journalism. Les journalistes américains se considèrent peut-être plus comme étant au service d’une communauté.

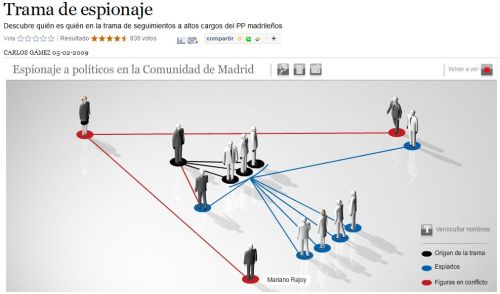

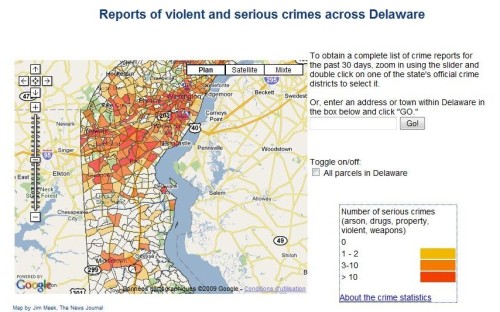

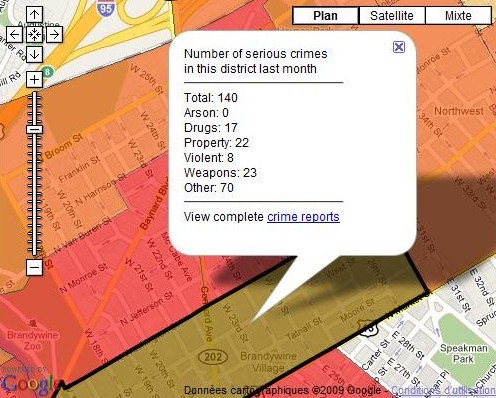

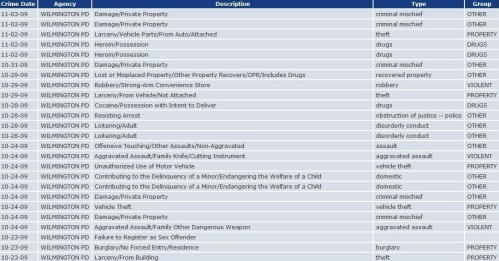

Aux Etats-Unis, les journalisme de données s’est beaucoup développé à l’échelon local avec du crimemapping et des services pratiques (les horaires d’ouvertures des magasins, par exemple). La référence en la matière reste EveryBlock d’Adrian Holovaty : un « agrégateur-visualiseur » de données micro-locales (critiques de restaurants, prix de l’immobilier, etc.).

Les données jouent un rôle important dans la valorisation des territoires. Le journalisme de données, au niveau hyperlocal, peut ainsi être utilisé par les rédactions pour générer de la proximité avec les communauté d’habitants pour lesquelles elles travaillent.

Côté environnement :

Une autre dimension doit être prise en compte : le journalisme de données ne dépend pas uniquement des journalistes, mais également des données à leur disposition.

Une culture de la transparence différente entre la France et les pays anglo-saxons

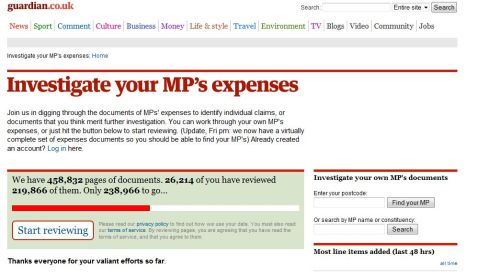

Et, là aussi, la France est à la traine par rapport aux anglosaxons. Les Etats-Unis et la Grande Bretagne se sont illustrés par leurs mouvements d’ouverture des données : avec les sites gouvernementaux data.gov et data.gov.uk, mais aussi avec de puissants militants de la cause de l’opendata, la Sunlight Foundation aux Etats-Unis, et le datablog du Guardian en Grande Bretagne.

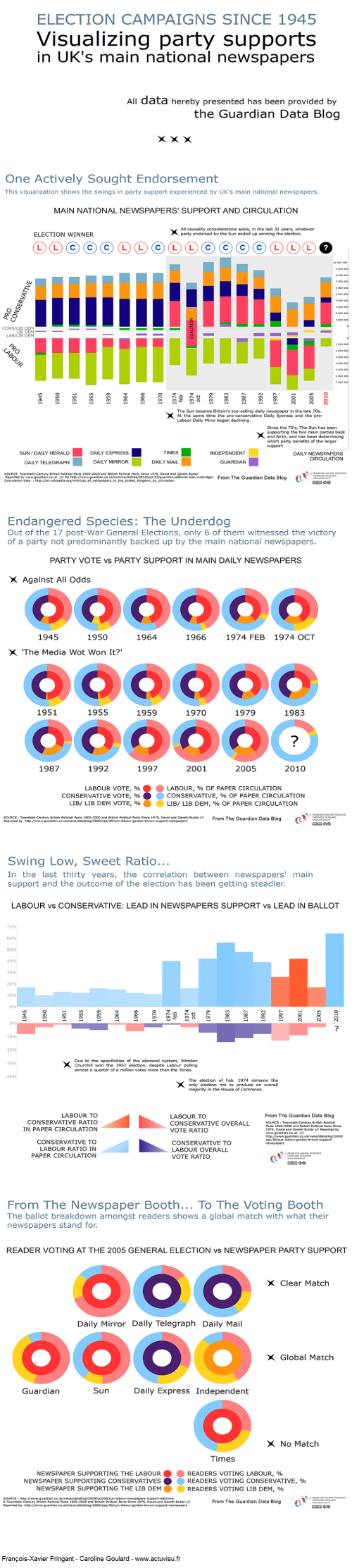

Ici encore, on pourrait invoquer un fossé culturel : la culture anglo-saxonne de la transparence dans la gestion publique n’a pas d’équivalent en France. La campagne « Give us back our crown jewels », portée par le Guardian en 2006, ne pourrait pas avoir d’écho sur nos terres républicaines. Pourtant elle a joué un rôle important dans la libération des données publiques en Grande Bretagne. Le Guardian a ainsi activement milité pour que les données collectées grâce à l’argent du contribuable britannique soient accessibles gratuitement, afin de stimuler l’innovation. Il a joué un rôle d’exemplarité en ouvrant ses propres bases de données (DataStore) et en organisant un concours d’applications basées sur ces données libérées. (Voir à ce sujet l’article de Jean Marc Manach « Les joyaux de la couronne n’appartiennent à personne »)

Pas de consensus sur la valeur économique de l’ouverture des données en France

Dans son plaidoyer pour l’ouverture des données, le Guardian insistait sur l’enjeu économique de l’ouverture des données publiques : une meilleure valorisation des données stratégiques, plus de services, plus d’opportunités commerciales, plus d’innovation, moins d’asymétrie informationnelle et donc des marchés plus efficients, et au final, un plus grand dynamisme économique.

En France, il n’y a pas de consensus sur la valeur économique des données publiques. Les entreprises dont l’activité repose sur la privatisation de données n’ont pas intérêt à leur ouverture. L’avantage économique de la libération des données ne s’est pas imposé face aux gains espérés de leur monétisation via la vente de licences. C’est ainsi, par exemple, que l’IGN continue à faire payer l’accès à une importante partie de ses bases de données. (voir ce précédent post pour plus d’info)

Les conditions juridiques de la réutilisation des bases de données

Sans aller jusqu’à dire que l’appareil juridique français est un frein à l’ouverture des données, il faut garder en tête certaines particularités de notre droit des bases de données.

Premier point : le droit d’auteur. Les données brutes ne sont pas, en elles-mêmes, soumises au droit d’auteur mais une base de données peut être protégée par le droit d’auteur si elle découle d’un acte de création intellectuelle, c’est-à-dire si elle témoigne d’une originalité caractérisée. L’auteur de la base de données jouit alors d’un monopole d’exploitation de son œuvre (droits patrimoniaux) ainsi que de droits au respect de l’intégrité de son œuvre et au respect de sa paternité sur l’œuvre (droits moraux).

Deuxième point : le droit des producteurs de bases de données. Lorsque la création d’une base de données nécessite un investissement financier, humain et matériel substantiel, le droit des producteurs reconnaît au créateur un droit de protection analogue à celui de l’auteur sur son œuvre. Cette disposition est destinée à protéger l’investissement des personnes qui prennent l’initiative et le risque économique de créer une base de données. Cette protection garantit au producteur de la base de données un monopole d’exploitation, il peut interdire toute extraction substantielle de données de sa base.

Pour plus de détails voir la très bonne synthèse de Didier Frochot sur les-infostratèges.com et l’étude de la jurisprudence par Bernard Lamon.

Troisième point : la CNIL et les dispositions relatives à la protection de la vie privée. Toute base de données impliquant des données nominatives et/ou personnelles doit faire l’objet d’une déclaration à la CNIL. La collecte et la conservation des données d’une telle base sont également soumises à conditions (voire le site de la CNIL pour plus d’info). De même, doit être soumis à la CNIL tout croisement de bases de données qui aboutirait à qualifier des données personnelles.

L’enjeu de la structuration des données

Enfin, l’ouverture des données repose avant tout sur un enjeu d’accessibilité. Certes, on trouve aujourd’hui de nombreuses données chiffrées sur des organismes publics ou privés. Mais bien souvent ces données sont perdues au milieu de fichiers pdf, éparpillées entre des masses de texte, scannées en format image… et lorsqu’il s’agit de croiser de bases de données, on se retrouve face à des formats disparates et peu malléables… bref, les données sont rarement structurées.

D’accord, la loi du 17 juillet 1978 reconnaît à tout citoyen français le droit d’obtenir communication des documents détenus par une administration.

D’accord, une autorité administrative dédiée, la CADA (commission d’accès aux documents administratifs), veille au bon respect de ce droit d’accès aux documents administratifs.

Mais rien n’oblige les administrations à communiquer leurs données sous format numérique, encore moins de façon structurée.

Sur ce sujet, l’expérience de Nicolas Kayser-Bril est édifiante (voir l’article « On l’a pas en format ordinateur »).

Ce qu’aurait pu être le Sarkomètre du Nouvel Obs

Published 7 février 2010 Le database journalism : comment 7 CommentsÉtiquettes : données structurées, Nouvel Obs, opendata, Sarkomètre, visualisation

Avec son Sarkomètre, le Nouvel Obs a mis un pied dans les données structurées. Une avancée incontestable, mais si timide qu’elle souligne finalement l’ampleur du fossé qui sépare encore la presse traditionnelle de la visualisation de données.

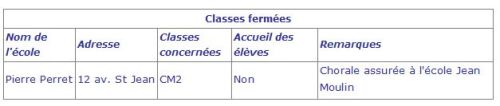

Reprenons. Le 1er février dernier, lenouvelobs.com publiait un tableau récapitulant, pour 113 promesses formulées par Nicolas Sarkozy pendant la dernière campagne présidentielle, si l’engagement a été tenu, oublié ou engagé.

La base de données constituée par les journalistes comprend également, pour chaque promesse, sa thématique, la déclaration originelle du candidat Sarkozy, et un commentaire de la rédaction du Nouvel Observateur.

Il s’agit effectivement d’une démarche de structuration de données : publier dans un tableau ce qui d’ordinaire est publié par le Nouvel Obs sous forme d’article, de récit, en croisant des indicateurs (thème, promesse, déclaration, réalisation, commentaire) et des variables (les 113 promesses).

Le Nouvel Obs reprend ici la démarche de Politifact, avec son Obameter (The Obameter : Tracking Obama’s Campaign Promises), qui a noté plus de 500 promesses faites par Barack Obama pendant sa dernière campagne selon leur degré de réalisation (Promise Kept, Compromise, Promise Broken, Stalled, In the Works, Not yet rated).

Politifact est un projet de journalisme innovant lancé par Matt Waite au sein du St. Petersburg Time en 2008, pendant la campagne pour les élections présidentielles aux Etats-Unis : le site évaluait la véracité des propos tenus par les hommes politiques sur une échelle allant de « True » à « False » en passant par « Mostly True », « Half True » et « Barely True ».

Revenons d’abord sur le principal bon point du Sarkomètre : il a été publié via Socrata, une plateforme d’hébergement et de publication de bases de données. Avantages de la solution Socrata :

En passant par Socrata, le Nouvel Obs respecte tous les codes de l’open data. La base de donnée est libre, et cela représente une petite révolution dans un univers journalistique plutôt enclin à s’accrocher aux droits d’auteurs.

Maintenant cette belle avancée signalée, venons-en aux insuffisances.

Le tableau réalisé par le Nouvel Obs nous permet d’échapper à un article long, répétitif, encombré de formules destinées garder l’attention du lecteur tout en déroulant les 113 promesses. C’est déjà un beau progrès, mais le Nouvel Obs aurait pu aller beaucoup plus loin.

Le Sarkomètre ne nous permet pas de nous rendre compte instantanément que sur 103 promesses :

-31 ont été tenues

-39 ont été engagées

-43 ont été oubliées

Il ne nous permet pas de voir du premier coup d’œil que les thématiques ayant fait l’objet du plus grand nombre de promesses sont :

-La fiscalité (10 promesses)

-La famille (8 promesses)

-La santé (8 promesses)

-L’éducation (7 promesses)

Et que ces thématiques affichent des taux différents de conversion des promesses en engagements tenus :

-Fiscalité : promesses tenues à 40% (4 promesses tenues sur 10)

-Famille : promesses tenues à 0% (0 promesse tenue sur 8 )

-Santé : promesses tenues à 25% (2 promesses tenues sur 8 )

-Education : promesses tenues à 29% (2 promesses tenues sur 7)

Pour cela, il aurait fallu que le Nouvel Obs réfléchisse à la visualisation de sa base de données.

Voyons maintenant ce que le Sarkomètre aurait pu être.

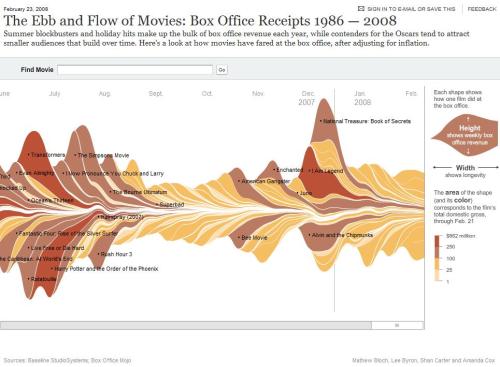

Puisque je n’ai ni le temps ni l’équipe nécessaire à la réalisation de ces visualisations (mais il pourrait un jour en être autrement), je vous propose simplement quelques exemples de graphisme.

Le Sarkomètre aurait pu proposer :

Comme sur l’Obameter :

Comme pour l’agenda du président Obama analysé par le Washington post :

Ou à la façon de Where does my money go

Comme sur cette visualisation de l’évolution du pouvoir d’achat des foyers américains sur Flowing Data :

Comme la timeline d’ABC News sur la dernière campagne présidentielle américaine :

Comme sur Capitol Words :

Ou comme dans la rubrique In Obama’s Words du Washington Post :

Conclusion : structurer des donnée ne suffit pas, un travail d’éditorialisation est nécessaire pour faire ressortir des idées de la base de données.